【BS-008】のどちんこ責め M女りな</a>2015-02-27RASH&$ビザールスタイル82分钟 ACL 2024大奖揭晓!全华东说念主团队用AI破解3000年前甲骨文密码

【BS-008】のどちんこ責め M女りな2015-02-27RASH&$ビザールスタイル82分钟

【BS-008】のどちんこ責め M女りな2015-02-27RASH&$ビザールスタイル82分钟

新智元报说念

剪辑:剪辑部

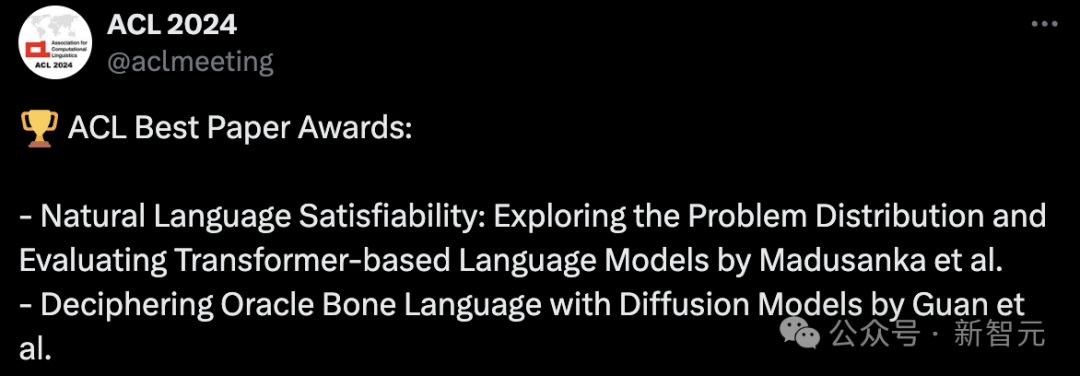

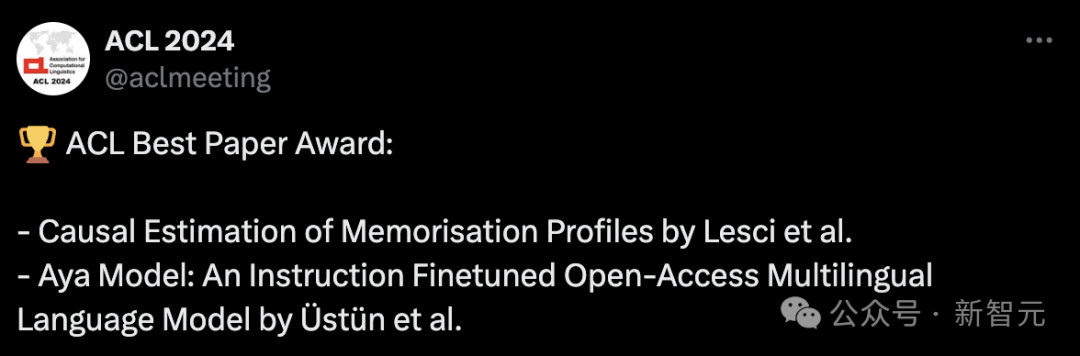

【新智元导读】一年一度NLP顶会ACL揭晓了最终获奖论文。本年,共有7篇论文荣获最好论文,技巧考试奖颁给斯坦福GloVe、康奈尔大学同样性度量。另外,还有最好主题奖、最好社会影响力奖、最好资源奖、边界主席奖,以及凸起论文奖。

ACL 2024终于授奖了!

共有7篇最好论文,35篇凸起论文,还有技巧考试奖、SAC奖、最好主题论文、最好资源论文奖等一并公布。

值得一提的是,7篇最好论文中,Deciphering Oracle Bone Language with Diffusion Models由全华东说念主团队完成。

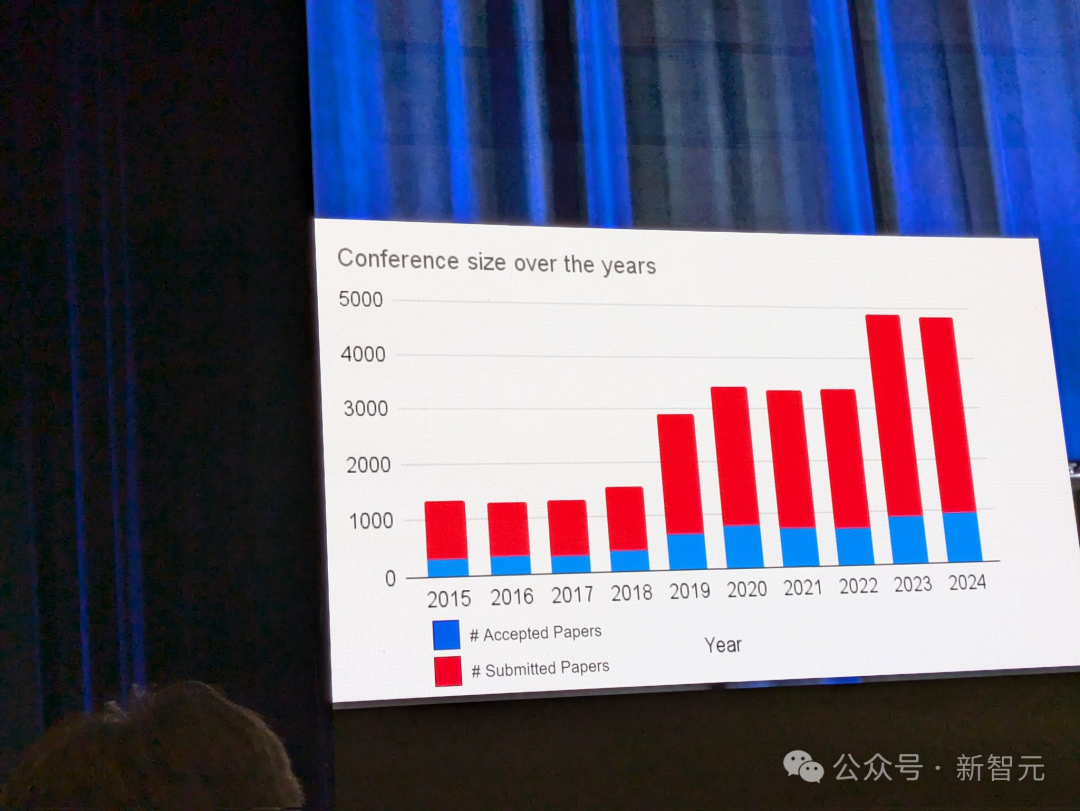

本年是海外蓄意说话学年会(ACL)第26届会议,于8月11-16日在泰国曼谷开幕。

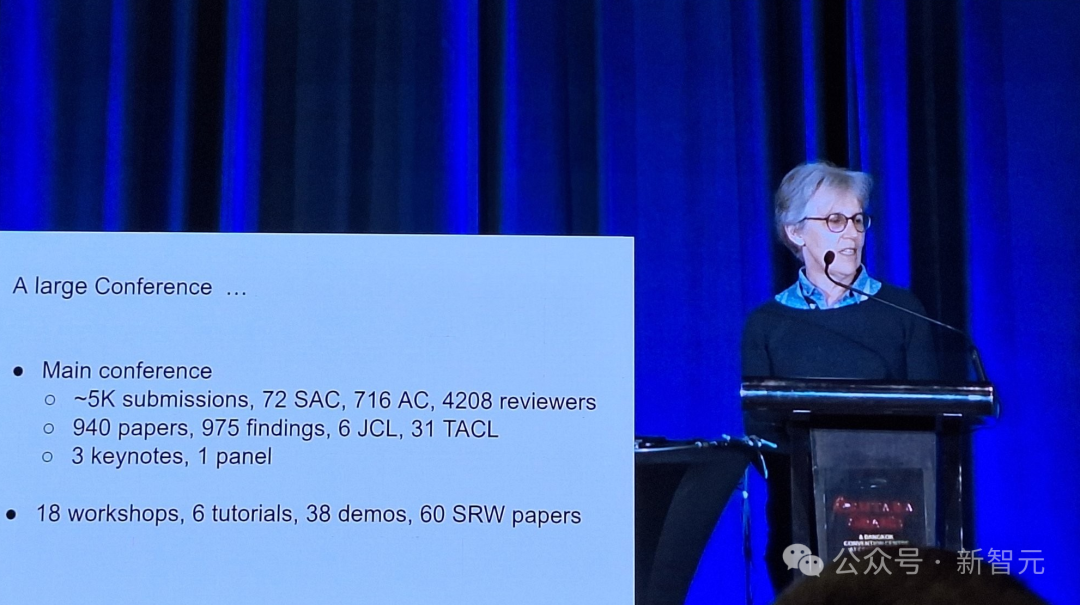

ACL 2024的论文总提交量与2023年收支无几,大致为5000篇,其中940篇论文被接受。

本届ACL号称有史以来,最大的一次,共有72名SAC、716名AC、4208位审稿东说念主。

975篇findings论文,6篇JCL、31篇TACL,还有3个主题演讲,1个panel。

整场会议还包含了18个workshop、6个tutorial、38个demo,60篇SRW论文。

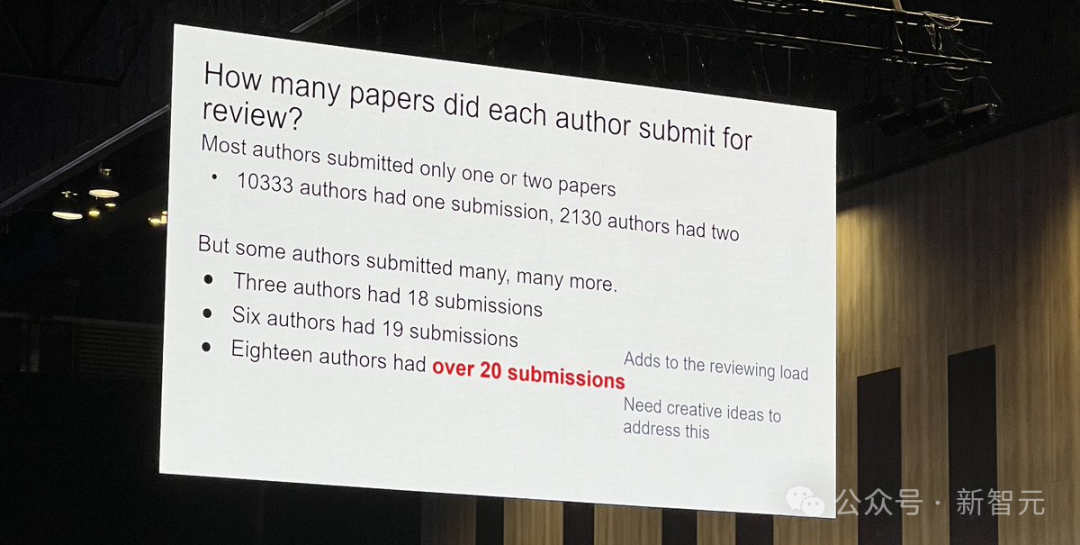

论文作产品体提交论文情况如下:

大多数东说念主提交了1篇/2篇论文:有10333名学者提交了1篇,2130东说念主提交了2篇

少部分东说念主提交了多篇论文:有3位作家提交了18篇,6东说念主提交了19篇,18东说念主提交了超20篇。

一齐望望,本年王人有哪些团队荣获大奖?

7篇最好论文

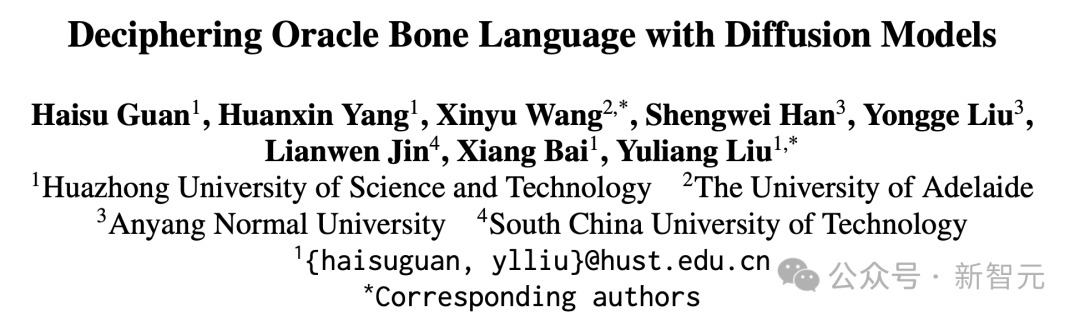

论文1:Deciphering Oracle Bone Language with Diffusion Models

作家:Haisu Guan, Huanxin Yang, Xinyu Wang, Shengwei Han, Yongge Liu, Lianwen Jin, Xiang Bai, Yuliang Liu

机构:华中科技大学、阿德莱德大学、安阳师范学院、华南理工大学

如题所示,华东说念主团队用AI作念了一件额外真义且有价值的事——借助扩散模子破译甲骨文(OBS)。

甲骨文发祥于大要3000年前的中国商朝,是说话史上的一块基石。

尽管东说念主们一经发现了数以千计的碑文,但甲骨文的无数内容仍未被破译,为这一陈腐的说话蒙上了一层高明的面纱。

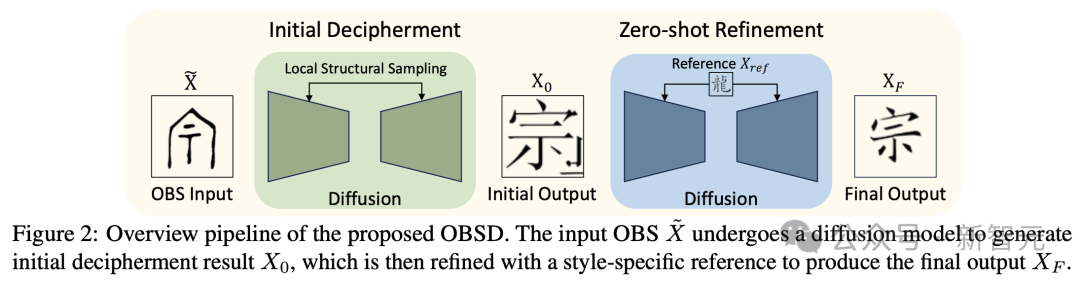

论文中,作家先容了一种领受图像生成AI的新才略,终点是研发出「Oracle Bone Script Decipher」(OBSD)。

讹诈基于条目扩散的政策,OBSD生成了要害的破译踪迹,为AI赞助分析古代说话开荒了一条新路。

为了考证其灵验性,征询东说念主员在甲骨文数据集上进行了无数实验,量化完了阐明了OBSD的灵验性。

论文2:Natural Language Satisfiability: Exploring the Problem Distribution and Evaluating Transformer-based Language Models

(暂未提交预印本)

论文3:Causal Estimation of Memorisation Profiles

作家:Pietro Lesci, Clara Meister, Thomas Hofmann, Andreas Vlachos, Tiago Pimentel

机构:剑桥大学、苏黎世联邦理工学院

领略LLM的顾虑,对履行和社会有细心要的影响,比如征询模子教练动态或防御版权侵权。

先前的征询,将顾虑界说为通过实例教练,对模子展望该实例的才略,产生的因果反馈。

这个界说依赖于一个反事实:粗略不雅察到模子莫得看到该实例时会发生什么。

然则,现存的才略常常针对模子架构,而非特定模子实例估算顾虑,很难提供蓄意后果高,且准确的反事实臆测。

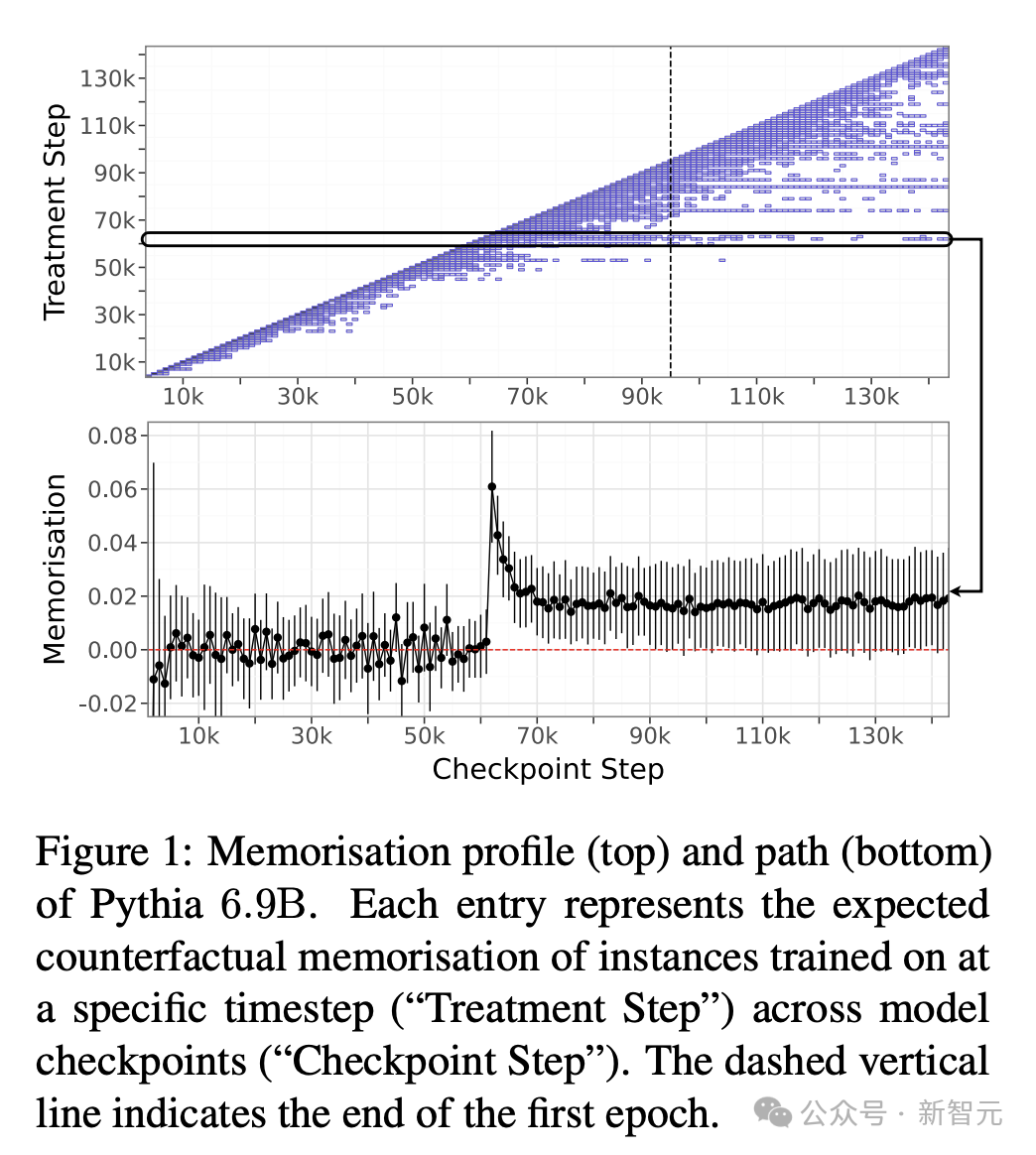

这项征询填补了一个要害空缺,作家基于计量经济学中的差分联想,提议了一种原则性且高效的新才略来臆测顾虑化。

讹诈这种才略,只需在通盘教练历程中,不雅察一小部分实例的行径,就能描绘出模子的顾虑概况,即模子在通盘教练历程中的顾虑趋势。

在Pythia模子套件的实验中,征询东说念主员发现:

(1)大型模子的顾虑性更强、更合手久;

(2)由数据端正和学习率决定;

(3)在不同边界的模子中具有自如的趋势,因此大型模子的顾虑与微型模子的顾虑具有可展望性。

论文4:Aya Model: An Instruction Finetuned Open-Access Multilingual Language Model

作家:Ahmet Üstün【BS-008】のどちんこ責め M女りな2015-02-27RASH&$ビザールスタイル82分钟, Viraat Aryabumi, Zheng-Xin Yong, Wei-Yin Ko, Daniel D'souza, Gbemileke Onilude, Neel Bhandari, Shivalika Singh, Hui-Lee Ooi, Amr Kayid, Freddie Vargus, Phil Blunsom, Shayne Longpre, Niklas Muennighoff, Marzieh Fadaee, Julia Kreutzer, Sara Hooker

机构:Cohere For AI、布朗大学、Cohere、Cohere For AI Community、卡内基梅隆大学、麻省理工学院

本年2月,初创公司Cohere发布了一款名为Aya全新开源的大边界说话生成式大模子,掩饰了超101种说话。

值得一提的是,Aya模子说话模子掩饰范围,是现存开源模子两倍多,杰出了mT0和BLOOMZ。

东说念主类评估得分达到75%,在各项模拟胜率测试中得分为80-90%。

这一花式得以初始,汇集了来自119个国度的超3000名孤立征询东说念主员的力量。

此外,征询东说念主员还公开了迄今为止最大的多说话疏导微调数据集,包含513百万条数据,涵盖114种说话。

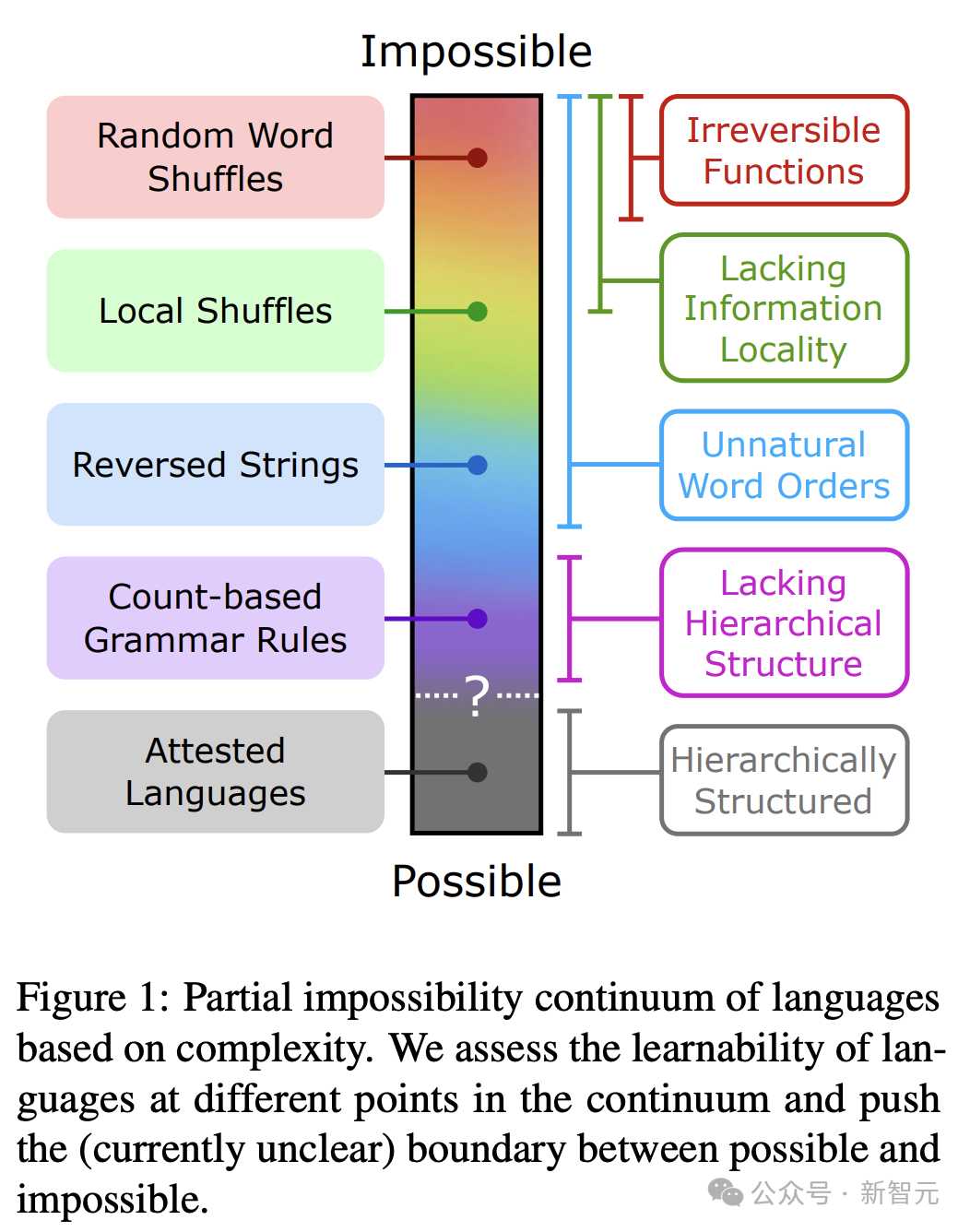

论文5:Mission: Impossible Language Models

作家:Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts

机构:斯坦福大学、加州大学尔湾分校、得克萨斯大学奥斯汀分校

乔姆斯基等东说念主曾直言说念,LLM在学习东说念主类可能和不成能学习的说话方面具有同等才略。

然则,很少有公缔造表的实考把柄,复古这种说法。

为此,征询东说念主员缔造了一组复杂进度不同的合成「不成能说话」,每种说话王人是通过系统地篡改英语数据,并用非当然词序和语法章程联想而成。

这些说话处在不成能说话的贯穿体上:一端是饱和不成能说话,比如连忙重排的英语;另一端是在说话学上被觉得是不成能说话,比如基于词位置计数章程。

经过一系列评估,GPT-2在学习不成能说话方面,额外忙活,这对中枢不雅点提议了挑战。

更为要害的是,征询者但愿这种才略粗略激勉,更多对于LLM在学习不同类型说话方面才略的征询,以便更好地领略LLM在表露和说话类型学征询中的潜在应用。

论文6:Semisupervised Neural Proto-Language Reconstruction

作家:Liang Lu, Peirong Xie, David R. Mortensen

机构:卡内基梅隆大学、南加州大学

论文地址:https://arxiv.org/pdf/2406.05930

现存的原生说话比较重建责任,常常需要全程监督。

然则,历史重建模子惟有在使用有限的标注数据进行教练时,才具有实用价值。

对此,征询东说念主员提议了一种半监督历史重建任务。

在这种任务中,模子只需在极少标注数据(有原形的同源集)和无数无标注数据(无原形的同源集)的基础上进行教练。

作家研发出一种用于比较重建的神经架构——DPD-BiReconstructor,其中包含了说话学家比较才略中的一个要害不雅点:重建词不仅不错从其子词中重建出来,还不错细目性地调养回其子词中。

征询标明,这种架构粗略讹诈未标志的同源词集,在这项新任务中的施展优于现存的半监督学习基线。

论文7:Why are Sensitive Functions Hard for Transformers?

作家:Michael Hahn, Mark Rofin

机构:萨尔大学

论文地址:https://arxiv.org/pdf/2402.09963

实证征询一经发现了Transformer模子一系列可学习性偏差和局限性,比如在学习蓄意简便花样说话(如PARITY)时长期存在隆重,而且倾向与低阶函数。

然则,表面上的领略仍然有限,现存的抒发才略表面要么过度展望,要么低估了骨子的学习才略。

征询东说念主员阐明,在Transformer架构下,亏本景不雅(loss landscape)受到输入空间明锐性的敛迹:

那些输出对输入字符串的多个部分明锐的Transformer模子,在参数空间中占据孤独点,导致在泛化中出现低明锐度偏差。

征询从表面和实证角度阐明,最新表面长入了对于Transformer学习才略和偏差的惯犯领导不雅察,比如它们在饭还中,对地明锐度和低阶函数的偏好,以及在奇偶性问题上难以进行长度泛化。

这标明,领略transformer的归纳偏差不仅需要征询其原则上的抒发才略,还需要征询其亏本景不雅。

2篇技巧考试奖

论文1:GloVe:Global Vectors for Word Representation(2014)

作家:Jeffrey Pennington, Richard Socher, Christopher Manning

机构:斯坦福大学

论文地址:https://nlp.stanford.edu/pubs/glove.pdf

词镶嵌(word embedding)是2013年至2018年间NLP深度学习才略的基石,况且延续产生要紧影响。它们不仅晋升了NLP任务的性能,还在蓄意语义方面具有权臣影响,如词同样性和类推。

最具影响力的两种词镶嵌才略可能是skip-gram/CBOW和GloVe。与skip-gram比拟,GloVe提议得更晚,其相对上风在于其主张上的简便性——成功基于单词的散播特征优化它们在向量空间中的同样性,而不是简略化说话建模的角度,将其行动一组参数进行波折优化。

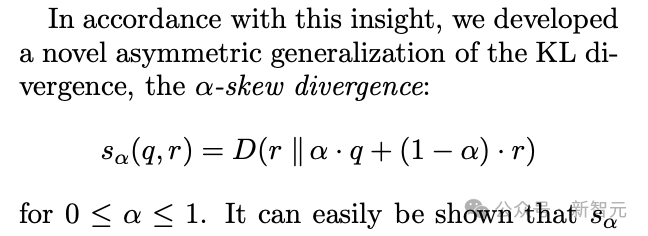

论文2:Measures of Distibutional Similarity(1999)

作家:Lillian Lee

机构:康奈尔大学

征询散播同样性度量,策动是改良对未见的共现(concurrence)事件的概率臆测,十分于另一种方式表征单词间的同样性。

论文的孝顺有三方面:对多样度量方式的粗造实证比较;基于同样度函数所包含的信息进行分类;引入了一种新函数,在评估潜在代理散播方面施展出色。

1篇最好主题论文

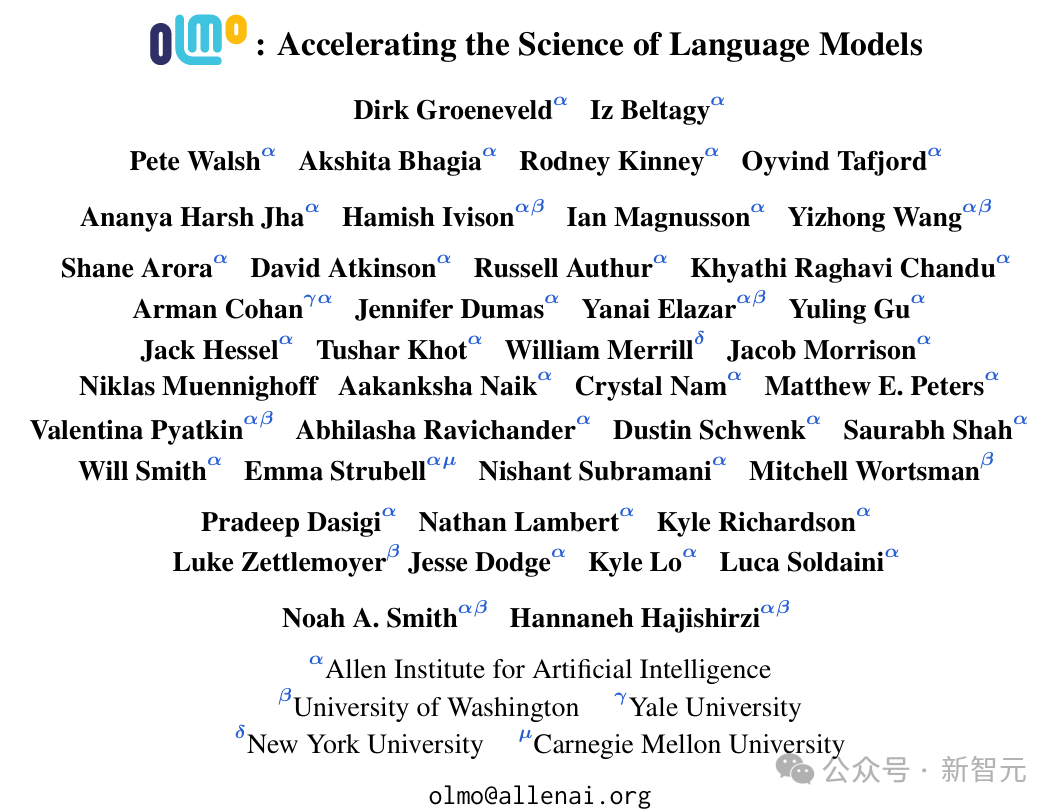

论文:OLMo: Accelerating the Science of Language Models

作家:Dirk Groeneveld, Iz Beltagy, Pete Walsh, Akshita Bhagia, Rodney Kinney, Oyvind Tafjord, Ananya Harsh Jha, Hamish Ivison, Ian Magnusson, Yizhong Wang, Shane Arora, David Atkinson, Russell Authur, Khyathi Raghavi Chandu, Arman Cohan, Jennifer Dumas, Yanai Elazar, Yuling Gu, Jack Hessel, Tushar Khot, William Merrill, Jacob Morrison, Niklas Muennighoff, Aakanksha Naik, Crystal Nam, Matthew E. Peters, Valentina Pyatkin, Abhilasha Ravichander, Dustin Schwenk, Saurabh Shah, Will Smith, Emma Strubell, Nishant Subramani, Mitchell Wortsman, Pradeep Dasigi, Nathan Lambert, Kyle Richardson, Luke Zettlemoyer, Jesse Dodge, Kyle Lo, Luca Soldaini, Noah A. Smith, Hannaneh Hajishirzi

机构:艾伦东说念主工智能征询所、华盛顿大学、耶鲁大学、纽约大学、卡内基梅隆大学

这项责任是提魁伟说话模子教练透明性和可重叠性的要紧进展,这是社区为了获取进展(或者至少是为了让除了行业巨头以外的其他孝顺者也能为进展作念出孝顺)而进犯需要的。

3篇最好社会影响力奖

论文1:How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs

作家:Yi Zeng, Hongpeng Lin, Jingwen Zhang, Diyi Yang, Ruoxi Jia, Weiyan Shi

机构:弗吉尼亚理工大学、中国东说念主民大学、加州大学戴维斯分校、斯坦福大学

这篇论文探讨了绕过罢休这一东说念主工智能安全主题。它征询了一种在社会科学征询边界缔造的才略。该征询极具劝诱力,并有可能对社区产生要紧影响。

论文2:DIALECTBENCH: An NLP Benchmark for Dialects, Varieties, and Closely-Related Languages

作家:Fahim Faisal, Orevaoghene Ahia, Aarohi Srivastava, Kabir Ahuja, David Chiang, Yulia Tsvetkov, Antonios Anastasopoulos

机构:乔治梅森大学、华盛顿大学、圣母大学、RC Athena

方言变异是当然说话处置和东说念主工智能中一个征询不及的表象。然则,对它的征询具有极高的价值,不仅在说话学和社会角度上,而且对应用也有要害影响。这篇论文提议了一个转换的基准,用于在大说话模子期间征询这一问题。

论文3:Having Beer after Prayer? Measuring Cultural Bias in Large Language Models

作家:Tarek Naous, Michael J. Ryan, Alan Ritter, Wei Xu

机构:佐治亚理工学院

这篇论文揭示了大说话模子期间的一个要害问题:文化偏见。诚然征询的配景是阿拉伯文化和说话,但完了标明,在联想大说话模子时,咱们需要探究文化的细小离别。因此,不错对其他文化进行雷同征询,以扩展并评估其他文化是否也受到这一问题的影响。

3篇最好资源论文

论文1:Latxa: An Open Language Model and Evaluation Suite for Basque

作家:Julen Etxaniz, Oscar Sainz, Naiara Perez, Itziar Aldabe, German Rigau, Eneko Agirre, Aitor Ormazabal, Mikel Artetxe, Aitor Soroa

机构:巴斯克大学

这篇论文详确地描绘了语料库集合和评估数据集的扫数细节。尽管他们征询的是巴斯克说话,但这种才略不错扩展用于构建低资源说话的大说话模子。

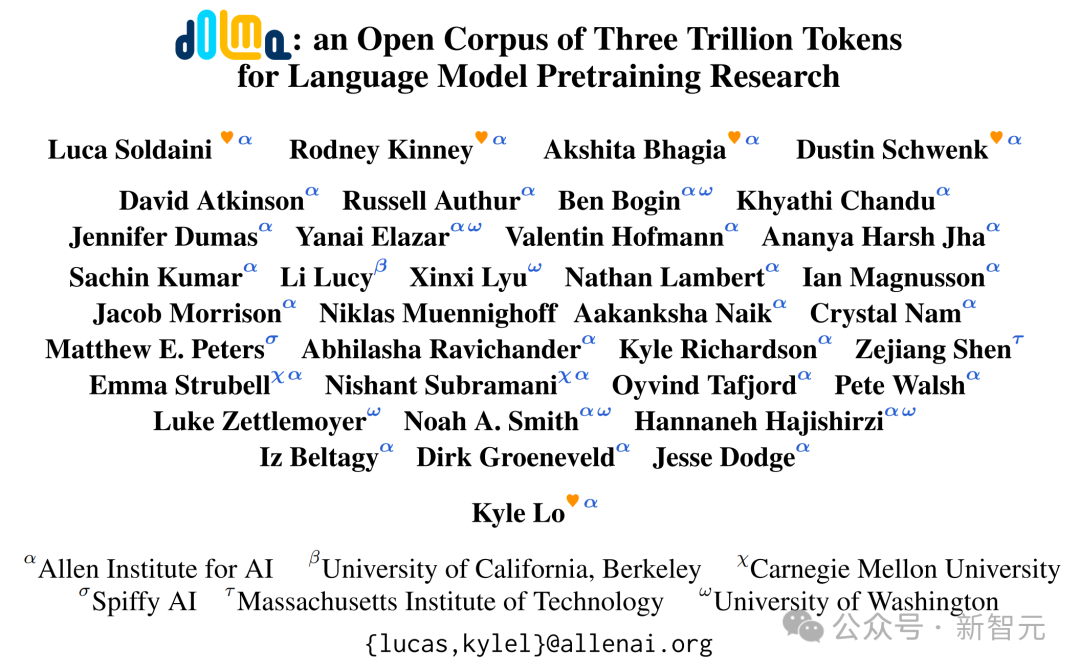

论文2:Dolma: an Open Corpus of Three Trillion Tokens for Language Model Pretraining Research

作家:Luca Soldaini, Rodney Kinney, Akshita Bhagia, Dustin Schwenk, David Atkinson, Russell Authur, Ben Bogin, Khyathi Chandu, Jennifer Dumas, Yanai Elazar, Valentin Hofmann, Ananya Harsh Jha, Sachin Kumar, Li Lucy, Xinxi Lyu, Nathan Lambert, Ian Magnusson, Jacob Morrison, Niklas Muennighoff, Aakanksha Naik, Crystal Nam, Matthew E. Peters, Abhilasha Ravichander, Kyle Richardson, Zejiang Shen, Emma Strubell, Nishant Subramani, Oyvind Tafjord, Pete Walsh, Luke Zettlemoyer, Noah A. Smith, Hannaneh Hajishirzi, Iz Beltagy, Dirk Groeneveld, Jesse Dodge, Kyle Lo

机构:艾伦东说念主工智能征询所,加州大学伯克利分校,卡内基梅隆大学、Spiffy AI、麻省理工学院、华盛顿大学

这篇论文呈报了在为大说话模子准备数据集时,数据策展的要害性。它提供了有价值的观点,不错惠及社区内的粗造受众。

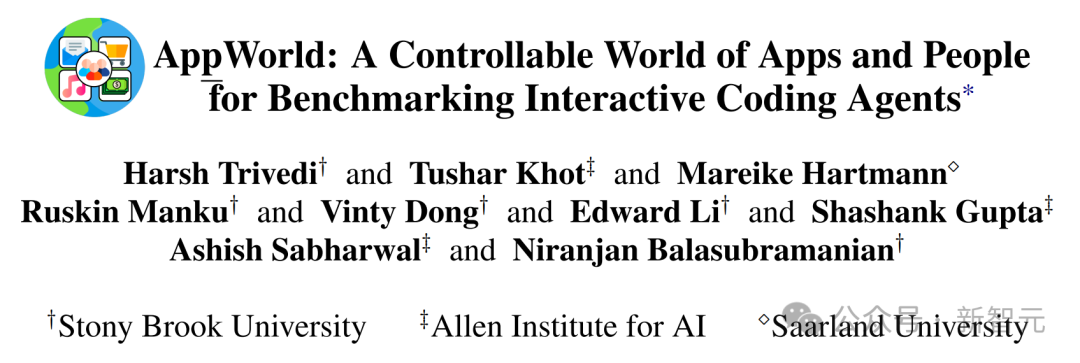

论文3:AppWorld: A Controllable World of Apps and People for Benchmarking Interactive Coding Agents

作家:Harsh Trivedi, Tushar Khot, Mareike Hartmann, Ruskin Manku, Vinty Dong, Edward Li, Shashank Gupta, Ashish Sabharwal, Niranjan Balasubramanian

机构:纽约州立大学石溪分校、艾伦东说念主工智能征询所、萨尔大学

这是一个相应时东说念主印象深切且要害的尝试——构建一个用于东说念主机交互的模拟器和评估环境。这将饱读舞为社区制作具有挑战性的动态基准。

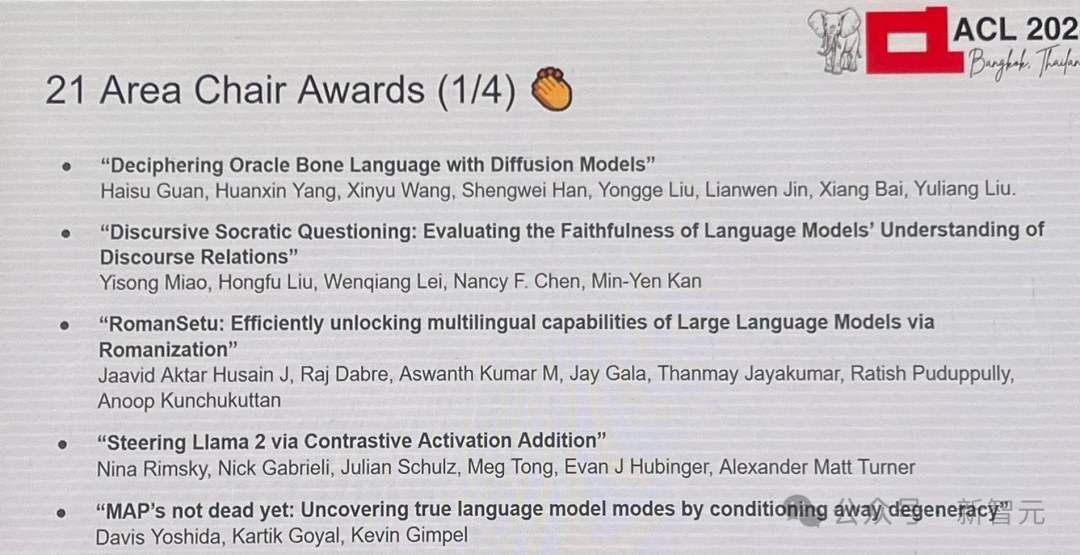

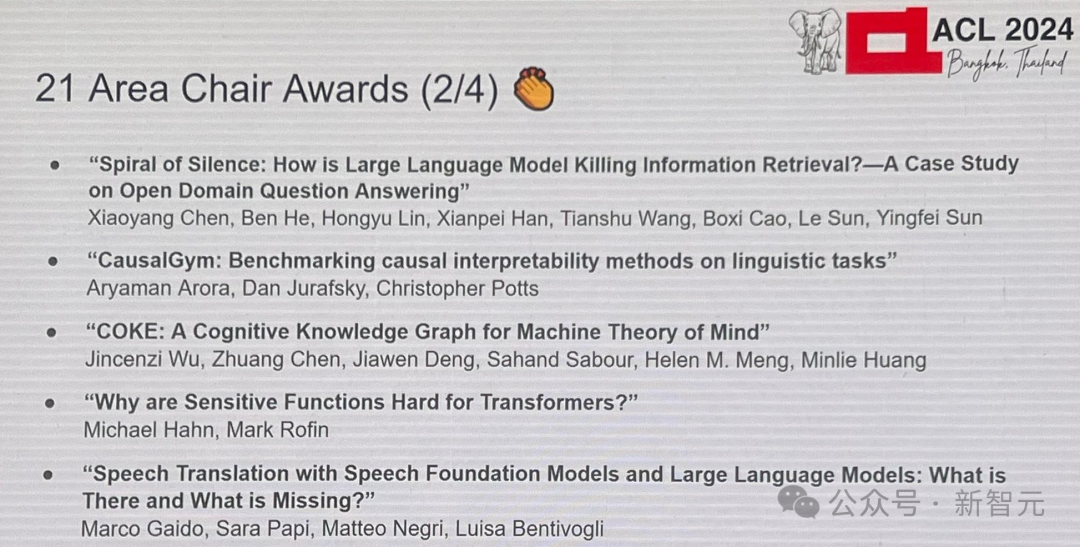

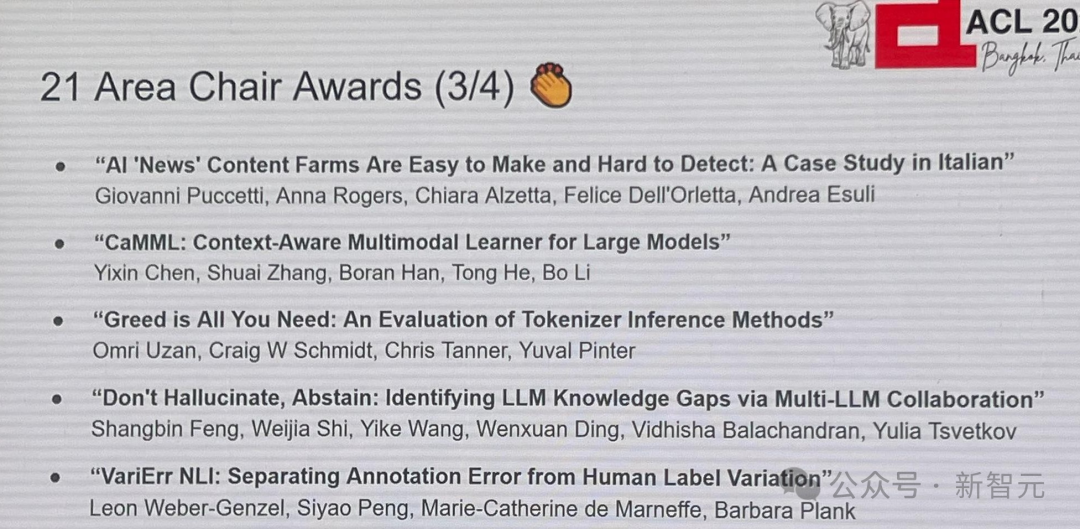

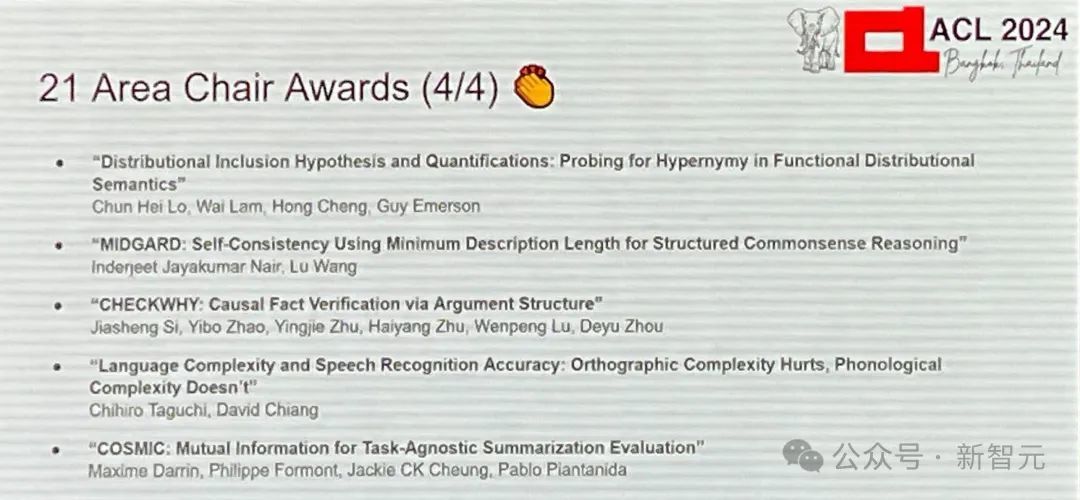

21篇边界主席奖

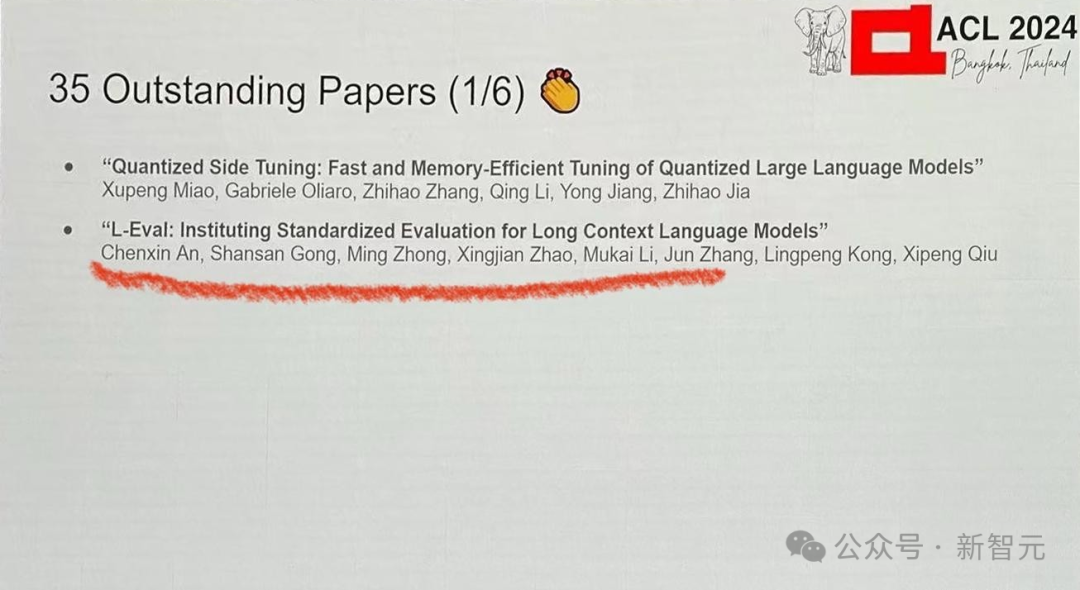

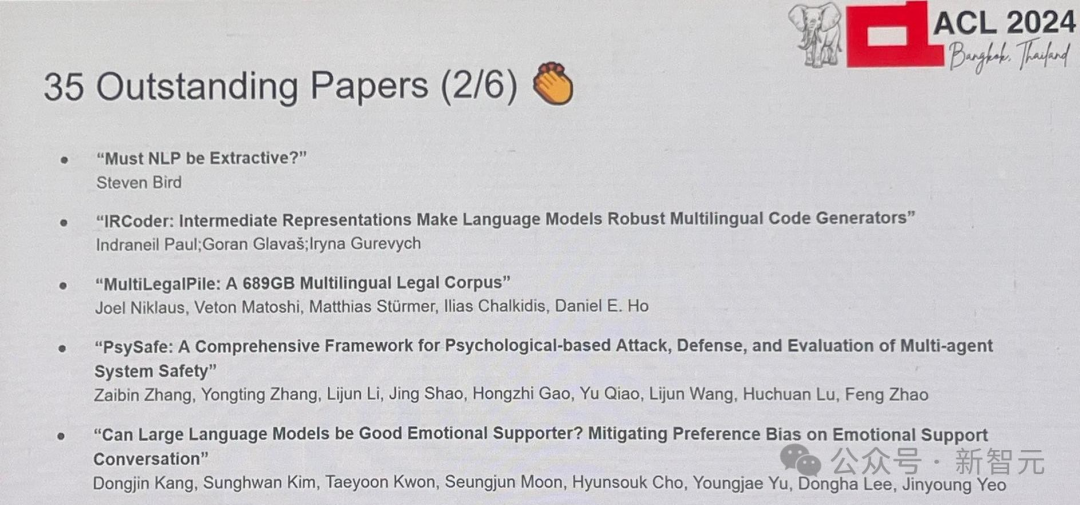

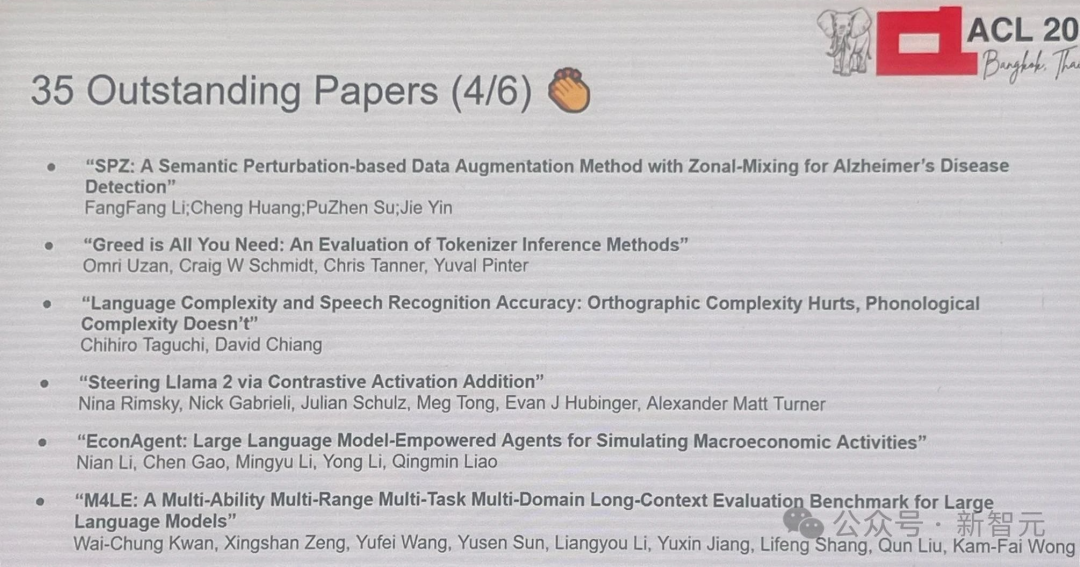

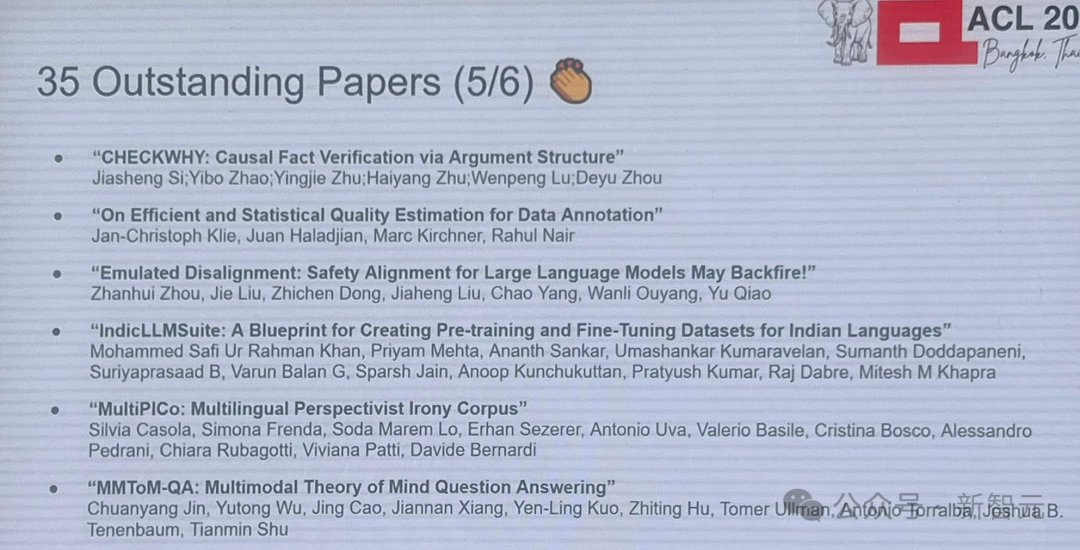

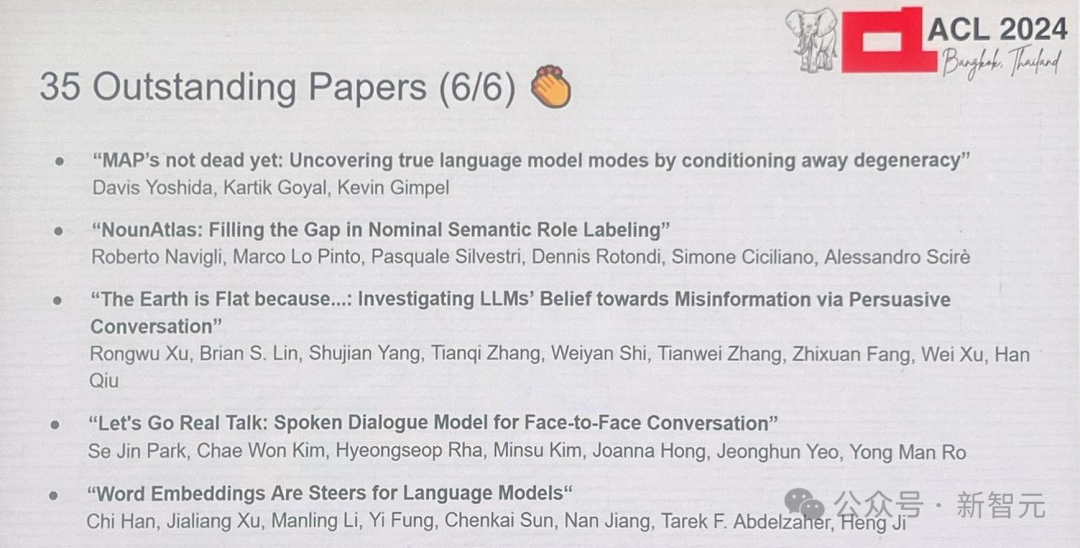

35篇凸起论文

(此图不齐备)

当前网址:http://www.137zt.com/jiqingwang/110635.html

tag:【BS-008】のどちんこ責め M女りな2015-02-27RASH@@$ビザールスタイル82分钟,ACL,2024,大奖,揭晓,华东

- 发表评论 (178人查看,0条评论)

-

- 最新评论